- 公開日:2019年01月30日

- | 更新日:2022年11月30日

AI(人工知能)とTIのAIへの取り組み

- ライター:Kaka

- その他

身近になりつつある人工知能(AI)

昨今、AIを活用したサービスや製品で画像認識、音声認識、言語翻訳、自動運転など様々な分野、業界で活用され、注目されています。実はAI自体は昔から取り組まれていた内容ということをご存知でしょうか?

この記事では、そもそもAIってどういうものなのか?という内容から、なぜ今、AIが注目を浴びているのか?を説明し、大手半導体ベンダーのTexas Instruments社(TI)が今後どうように取り組んでいく予定説明いたします。

AIの定義と歴史

・AIの定義

実は研究者によって解釈は千差万別で厳密な定義はありませんが、一般的な解釈として、「人工的に人間の知能を模倣するための概念および技術」で良いかと思います。

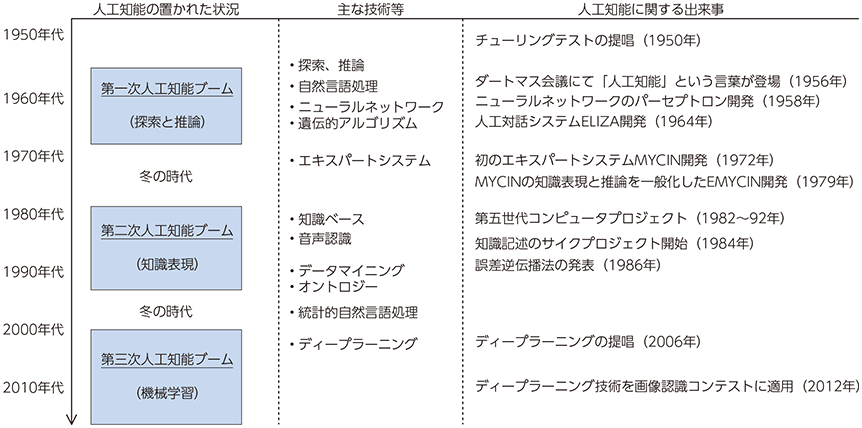

・AIの歴史

ここで冒頭で少し触れたようにAIの歴史について触れたいと思います。

AIの歴史は意外に古く、今まで3度のブームがありました。

第1次ブームは、1950年代後半から70年代前半に掛けてのことです。始めて「人工知能」という言葉が作られ、コンピューターによる「推論」や「探索」が可能となり、特定の問題に対して解を提示できるようになりました。ただし、トイプロブレム(迷路、パズル、チェスや将棋など、明確に定義されたルールの中で解を求める問題)は解けても実用上の問題はほとんど解けずに、冬の時代へ突入します。

その後、1980年代以降に第2次ブームが到来しました。

この時代は、「知識」(コンピューターが推論するために必要な様々な情報を、コンピューターが認識できる形で人が記述したもの)を与えることでAIが実用可能な水準に達し、多数のエキスパートシステム(専門分野の知識を取り込んだ上で推論することで、その分野の専門家のように振る舞うプログラム)が生み出されました。ただし、世の中にあるあらゆる知識をコンピュータに教え込ませ、管理すること自体が難しく、再び冬の時代を迎えました。

そして現在、第3次ブームとなっており、「ビッグデータ」と呼ばれている大量のデータ、演算能力の高いハードウェアが使える環境が整い、機械学習のアルゴリズムの進化、特に知識を定義する特徴量をAIが自ら習得するディープラーニングが登場したことがブームの背景となっています。

(出典)総務省「ICTの進化が雇用と働き方に及ぼす影響に関する調査研究」(平成28年)

ディープラーニングとは

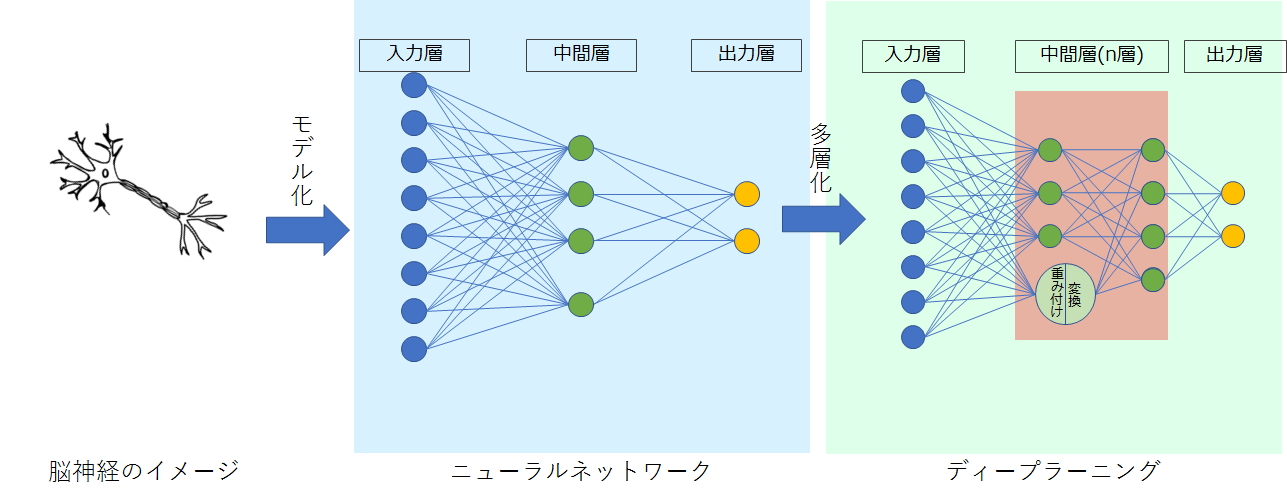

人間の脳の仕組みをモデル化したニューラルネットワークの最新技術です。人間の脳は、ニューロン(神経細胞)と、ニューロン間を結んで情報を伝えるシナプスから構成されますが、ニューラルネットワークはそのニューロンとシナプスをモデル化して作られたものです。このニューラルネットワークを何段階もの層が積み重なった構造を利用した機械学習のことです。

用語

機械学習: 入力された情報(=データ)から、プログラム自身が自分で学習することで識別や予測をする能力を身につける機能のこと。

ニューラルネットワーク: 人間の神経細胞を模したニューロンからなるモデル構造

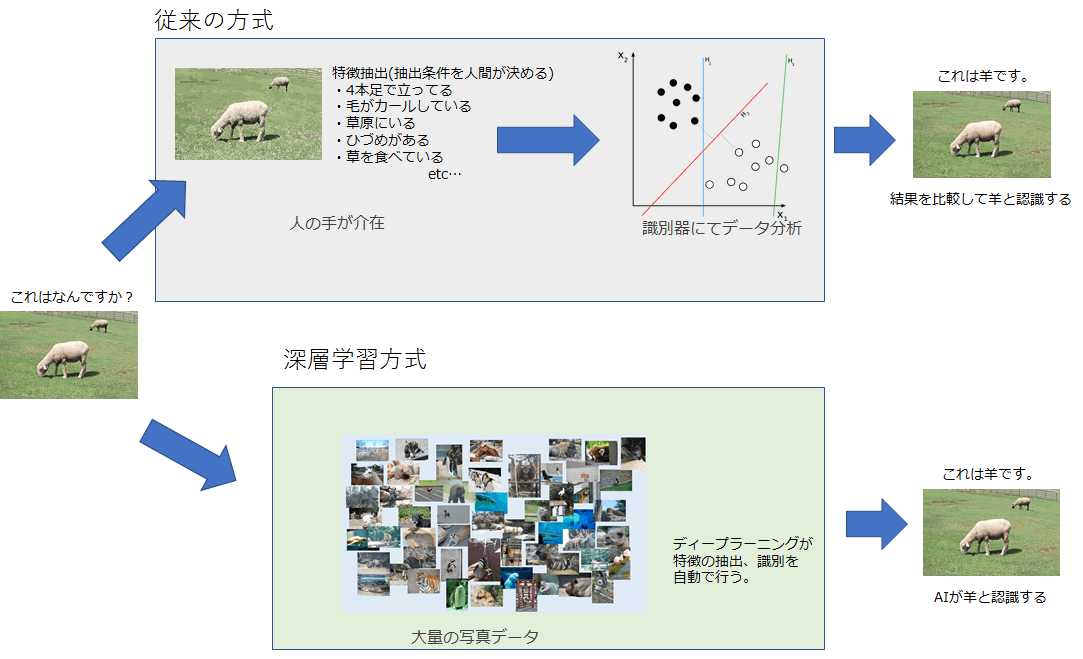

歴史でも触れましたが、ディープラーニングが登場したことが現在のブームの火付け役になっている背景として、今まではコンピュータに画像データを読み込ませて「これは猫」という判断をさせるのに、これまでコンピュータは、「猫は毛に覆われている」「4足で歩行する」「目が2つ」といった、猫の特徴を人間がコンピュータに入力する必要がありました。

ディープラーニングでは大量の画像データをコンピュータに読み込ませるだけで、そこから「これは猫」という法則を、コンピュータ自身が獲得すること(学習)ができるようになり、学習したモデルから未知のデータを入れて識別する(推論)精度も人間を超え始めているのです。

AIを使うには?

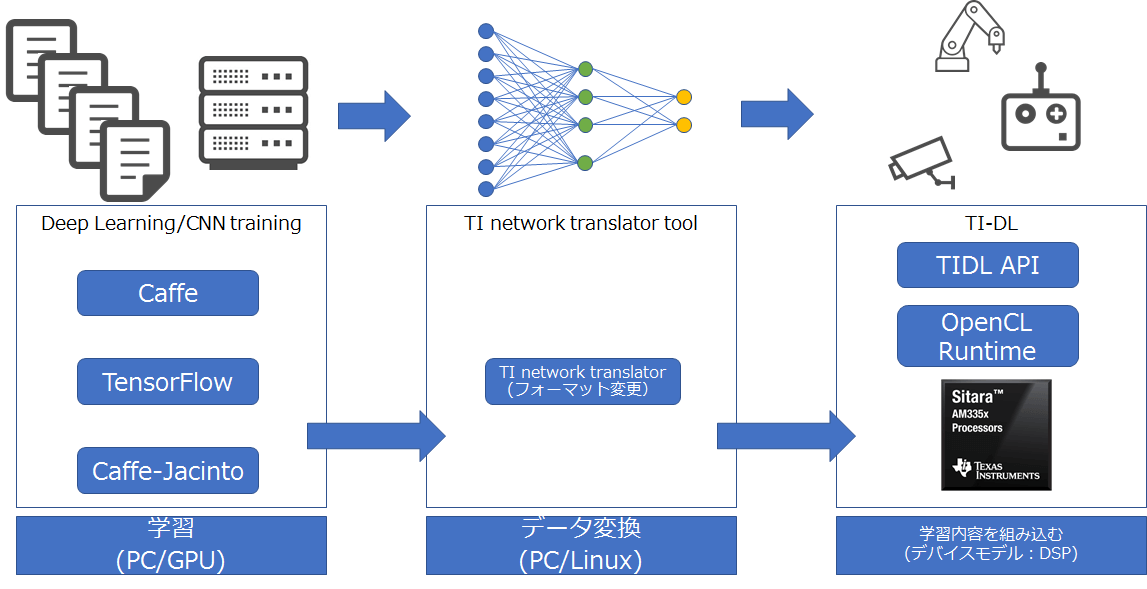

今回のブームが機械自身が特徴を見つけ出すディープラーニングによって引き起こされていることは理解いただけたかと思います。では、実際にAIを使うまでのフェーズを説明します。

1.機械自身が特徴を見つけるために“学習”フェーズ

機械自身で特徴を見つけるために学習モデルを生成する必要があります。このフェーズでは学習用の大量データとその演算を行う高機能なハードウェア(主にGPU)が必要になります。

2.学習したモデルを使って推論

実際に学習が終わったモデルを使って入力データから推論するフェーズになります。実際の推論を実施する、つまり、低消費電力デバイスが車線検出のようなアルゴリズムを実行するときは、リアルタイム性能と低消費電力が重要になります。

TIのAIへの取り組みは?

・TIの取り組み状況

CaffeやTensorFlowなどオープンフレームワークの大半はGPU向けに最適化されており、GPUを使用する場合は非常に高速に動作するようになっており、DSPはサポートされておりません。ただし、消費電力の観点で言えばDSPの消費電力はGPUよりもかなり小さく、ポータブル機器や電力要求が厳しいモバイルアプリケーションに対しては優位性があります。このような状況に対してTIでは推論部分に対応する“TIDL”を開発いたしました。

TIDLはTIの組込みデバイスでディープラーニングを実現する一連のコンポーネントで形成されており、精度、速度、メモリ使用量に関する最善のトレードオフを実現できます。加えて、GPUが搭載されたサーバで学習済みのモデルをTIデバイス向けに変換するツールを提供しておりますので導入までの敷居を下げることが可能です。

・TI-DLがサポートしているプラットフォームは?

現時点でサポートしているプラットフォームは以下の製品でサポートされており、最新のSDKにて動作を確認することができるようになっています。

- AM5749 (2xEVEs + 2xC66x DSPs):未リリース品

- AM5746 (2xC66x DSPs)

- AM572x (2xC66x DSPs)

- AM571x (1xC66x DSP)

- AM5706 (1xC66x DSP)

- AM5708 (2xC66x DSP)

SDK:http://www.tij.co.jp/tool/jp/PROCESSOR-SDK-AM57X

今後、サポートされるデバイスも増えてくるかと思いますので、引き続きTIの動向に注目です!

まとめ

いかがでしたでしょうか?今回はAIの概要とTIの取り組み状況をまとめさせて頂きました。これからAIを導入する方の参考になればと思います。デバイスに関してより詳細な情報をご希望の際は弊社までお問い合わせください。

関連情報

総務省:http://www.soumu.go.jp/johotsusintokei/whitepaper/ja/h28/html/nc142120.html